| 新闻 | 视频 | 博客 | 论坛 | 分类广告 | 购物 | 简体/繁体 | 广告服务 | 联系我们 | 关于万维 | 登录/注册 |

|

|

大家有看过父母的社交媒体吗?

我经常被爸妈手机里的短视频给震惊到,打开都是《体检都是骗局》《年轻人不想结婚,是被外来思想操纵!》,还有老年人在养老院里被扇耳光、婆媳矛盾的视频,情绪煽动性极强,即使有些在我看来“一眼假”,他们都深信不疑。

不光是父母,和周围人聊天时,也会发现在信息前所未有发达的当下,人与人之间的信息差却前所未有地大——

男性刷到的短视频经常有“天价彩礼”、“捞女”、“极端女权”,女性刷到的都是“家暴”、“杀妻案”、“性侵”;孩子看到的是“不幸的童年要用一生来治愈”,父母看到的是“可怜天下父母心”。

现在,几乎每个人都活在算法为自己量身打造的回音室里,无法听到外界的声音。甚至,算法正在悄悄改造我们的价值观,让我们和最亲密的人彼此对立、彼此割裂。

大脑本身擅长制造信息茧房

算法将其进一步放大

当我们遇到与自己价值观截然相反的人,第一反应往往是“怎么会有人这么想?太荒谬了”。

但如果深入了解就会发现,这一点也不奇怪,因为 ta 所接收的所有信息都在不断加固和维护这种价值观,以至于从 ta 的视角来看,这简直就是就是真理。

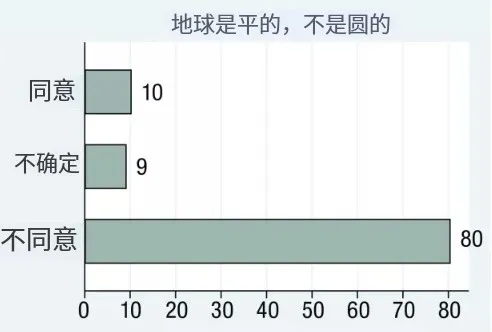

2021年调查显示,美国有10%的人认为地球是平的

图片来源:POLES 2021 survey[1]

比如,一个人相信“父母是绝对爱孩子的”,那 ta 大概率也会相信“打是亲,骂是爱”,相信父母做出任何事情都是为了孩子好。这些观点相互契合佐证,组成严丝合缝的拼图。

当 ta 听到“很多父母不爱孩子,只是想控制孩子”、“原生家庭会给孩子带来持久的创伤”时,如果要相信,就意味着原有的拼图被彻底推翻,于是大脑为了减少认知上的负担,更倾向于拒绝相信那些难以嵌入已有拼图的观点。

物理学家因为认知被颠覆而纷纷自杀

图片来源:《三体》

哈佛大学教授 Keith Sunstein 最早提出“信息茧房”这个概念的时候,就定义为,在广袤的信息宇宙里,我们只选择让我们舒适和愉快的东西[3]。

可以说,大脑天然擅长制造信息茧房,我们以为自己每天在接受新鲜的信息,其实只是源源不断地听到自己的回声,给陈旧的世界观大厦添砖加瓦而已。

算法则进一步放大这种倾向,它通过相似推荐、放大极端、操纵情绪等方法影响着我们的认知。

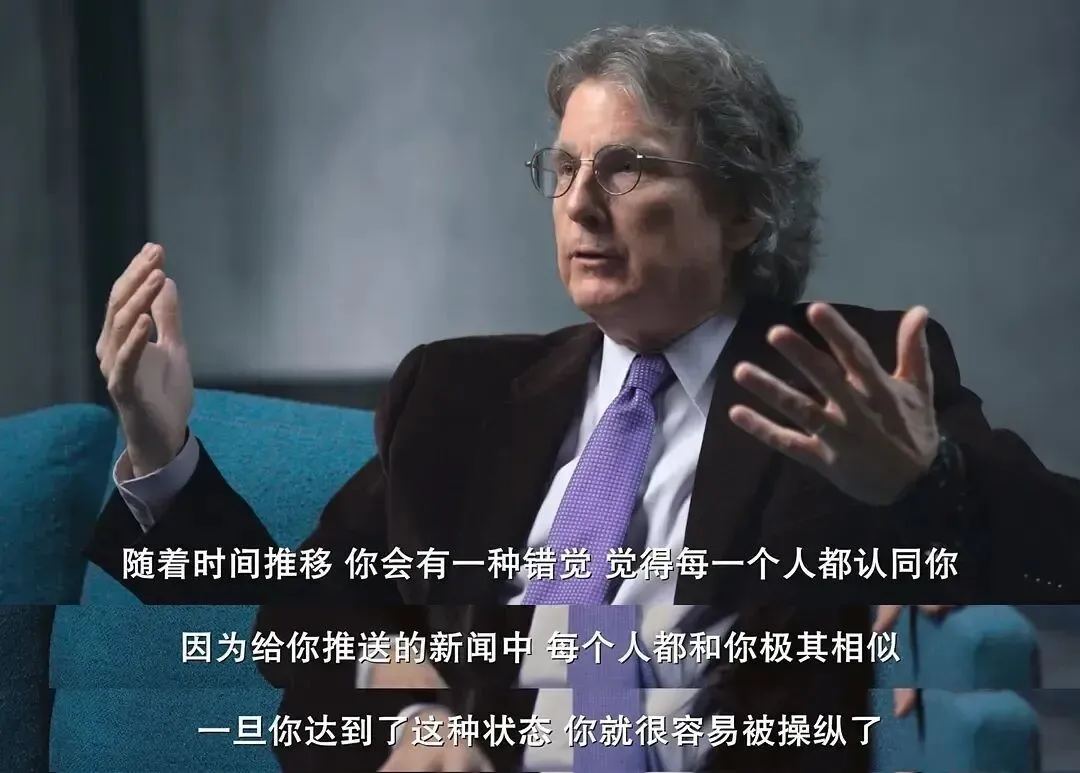

个性化推荐:根据你的点赞、停留和分享,推送更多相似内容,让你觉得“原来大家都这么想”、“这就是常识”;

放大极端个例:猎奇、冲突或极端的事件被反复推送,让你觉得“这种事遍地都是”;

正负反馈失衡:偏重正反馈(如点赞),忽略负反馈(如跳过),慢慢地你只能刷到你感兴趣的内容,形成信息孤岛。

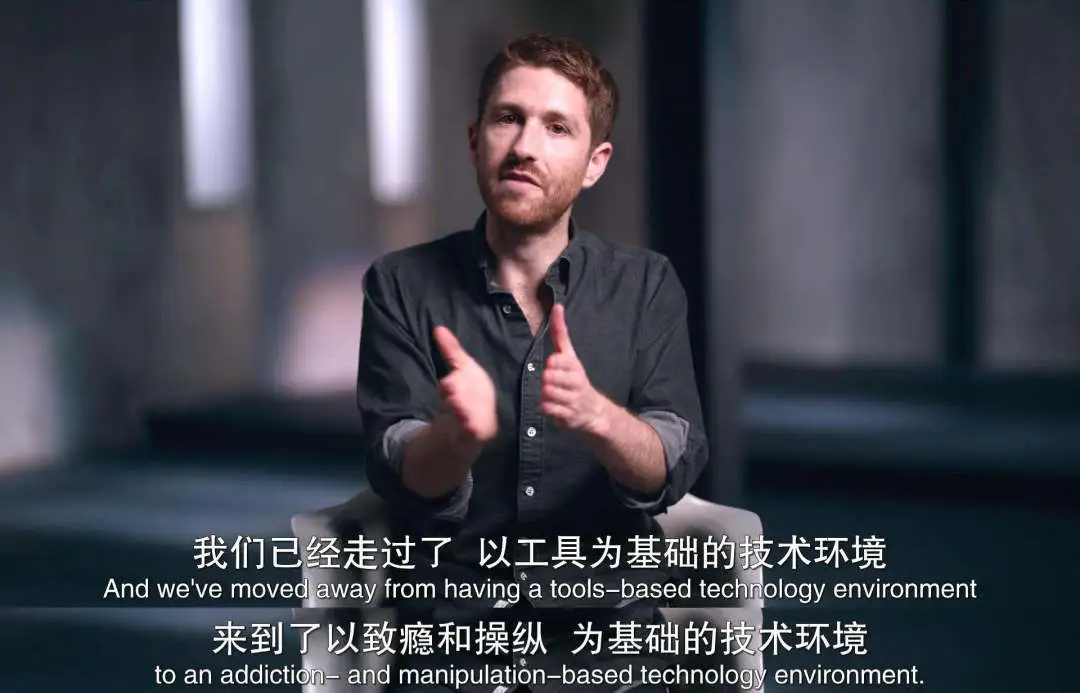

图片来源:《监视资本主义:智能陷阱》

处处迎合人类的算法,是如何

制造操控,加剧对立的?

当你的偏好被无限迎合

就会越来越无法忍受“不同”

我有一对情侣朋友在争吵后分别去找 AI 倾诉,聊完他们都觉得:AI 简直太懂我了,我没有错,该低头认错的是对方。

算法对于人的迎合和 AI 起到类似的效果,一个个帖子、一条条视频仿佛都是为自己量身定制,让人产生一种深深地被理解、被认同的感受——原来我是对的,原来不是我的错。

AI 对人类的谄媚

图片来源网络

这在一定程度上是好事,生活中被理解和认同的体验如此稀缺,网络和 AI 让它变得唾手可得。

但与此同时,个体的自恋被前所未有地放大,当人们习惯了处处迎合自己的网络环境,就越来越难以忍受现实生活中的真实摩擦,听到不同意见、不同观点,第一反应是抵触甚至愤怒。

我们可能会对亲近的人说“就连网上的陌生人都能理解我,为什么你不能?”、“这个博主讲的就是你这种人,你知道错了吗?”,不再把对方当成一个活生生的、有缺陷、有主体性的人,而是希望自己能永远被迎合,永远正确,自恋永不受损。

图片来源:《监视资本主义:智能陷阱》

哲学家约翰·杜威强调,如果一个环境总是处处迎合我们的冲动,那么它对成长的限制将和处处充满敌意的环境一样致命[4]。

因为成长恰恰来自于和“不同”“不舒服”的他者相遇,没有这种摩擦,我们会活在一个完美的镜像里——没有人能真正和我们相遇,我们也不再真正看见别人。

活在不同信息茧房里的人

无法说服彼此并走向各自的极端

群体极化(Group Polarization)是一种社会现象,指的是经过群体讨论后,个体的想法不会趋于中肯温和,而是会被推向更极端[3]。

比如,你本来只是觉得父母有一些地方做得不好,但当你进入一个不断吐槽原生家庭的群体时,群体内的共鸣和情绪会像放大器一样,让你越来越确信“父母皆祸害”、“一切都源于不幸的童年”。

和不同意见的群体聊天同样会加剧极化,比如一个人原本对于婚姻抱有疑虑,但在频繁看到“晒幸福”“催婚”的言论后,不仅不会向往,反而会更强烈地排斥婚姻,忍不住想寻找证据来证明“婚姻就是牢笼”。

于是,人们一边在同温层报团取暖,点赞自己认可的帖子,一边“排除异己”,在不认同的帖子下面花几个小时和陌生人争论,最终谁都不会被说服,只会让彼此都变得更加极端。

群体极化的危险在于,群体内部无限趋同,而群体和群体之间的分裂被无限放大,不同立场的人失去了对话的可能性,即使是身边亲近的人也难以互相理解。

在泛滥的虚假信息中

普通大众成为被误导和操控的对象

算法难以区分信息的真假,情绪化、夸张甚至虚假的内容,更容易在平台上被推向大众。

新周刊曾发布一篇文章名为《AI假新闻,霸占我的家族群》,其中列举了“五角大楼被炸”、“火车撞上修路工人”、“老人被殴打昏迷”等 AI 生成的假新闻,这些假新闻往往聚焦在城乡发展、阶层矛盾、性别对立、国际局势这些很有争议的话题,迅速博得巨大的流量[5]。

根据 Quest Mobile 发布的 2021 年《银发人口经济洞察报告 》,短视频已渗透到超过 80%的老年人[6],他们往往也是缺乏陪伴、在网络世界难以辨别虚假信息、容易受骗的群体。

在一些热点事件爆发的初期,网络上也总是传播大量的虚假信息,普通民众要么情绪被推到极端,要么慢慢变得麻木、冷漠。

走出信息茧房

从主动寻求不同开始

寻找突破性知识,留意那些

跟你的认知截然相反的内容

作家 Michael Simmons 把知识分为两种:增强性知识和突破性知识[7]。

增强性知识是加深我们固有认知的知识;

突破性知识会挑战我们关于世界如何运作的基础信念,或者提供一种全新的看待世界的方式,会对我们的人生产生漫长而深远的影响。

算法时代,我们被推送的往往都是增强性的知识,主动寻找突破性知识成了突破信息茧房的关键。

比如:

特意去查找跟你已有认知截然相反的观点,会发现相反的观点也有源源不断的证据,而自己所以为的“常识”并不是普遍真理;

试着跨不同的学科去看待同一个问题会焕然一新,意识到有不同的视角的存在,而自己的视角并不是唯一答案;

用主动阅读替代被动推送,比如对某些议题感兴趣就去找相关的书籍来阅读,对它有更体系化的认知后再去刷社交媒体,会更有分辨能力,而不是全盘接收;

走近一个真实的人类

不局限于待在同温层

我们常常能刷到这样的建议:“远离一切消耗你的人”、“莫与傻子论短长”。这些话听起来很有道理,但也让我们丧失和与自己不同的人交流的动力。

面对一个跟自己的三观差异很大的人时,我们可以试着不去区分对错好坏,而是意识到每个人接收到的信息可能天差地别,大家都被局限在自己的认知中,或许并没有谁比谁更正确。

而试着探究对方的世界观是如何形成的、为什么会做出这样的判断,就是在松动固有的认知拼图,让新的碎片有可能加入。

最后,你或许会发出这样的疑问:“做这些好累,我就不能想刷什么就刷什么,怎么舒服怎么来吗?”

对于这种真实也普遍的困惑,社会学家艾伦·约翰逊所说的“最小阻力路径”给了我很多启发:一个系统之所以能长久维持,是因为大多数人都会选择那条最轻松、最不费力的路径[8]。

比如一群人聚在一起开歧视的玩笑,跟着大家一起笑是最省力的,而站出来说“这个玩笑很冒犯”则是一条阻力更大、更难走的路。

当所有人都只想走最小阻力的路径时,就共同维护了系统的运转,当越来越多的人不玩这个游戏,选择那条更难走、但更符合自己心意的路时,旧系统就会自动瓦解。

当我们变得更有分辨能力,不再被极端、虚假的信息吸引,它们就自然会在信息的洪流中被淘汰,我们也在为更好的网络环境贡献一份自己的力量。

| 当前新闻共有0条评论 | 分享到: |

|

||||||||||

| 评论前需要先 登录 或者 注册 哦 |

||||||||||||

| 24小时新闻排行榜 | 更多>> |

| 1 | 习家“储君”出事?皇侄齐明正突然消失 |

| 2 | 北京七环大爆炸,传老习两口子躲了整整两天 |

| 3 | 习走错“关键一步” 渐失话语权 |

| 4 | 跨年夜,中国多个大城市现诡异一幕 |

| 5 | 大蒜是尿酸的杀手?想要肾脏健康这些蔬菜要 |

| 48小时新闻排行榜 | 更多>> |

| 一周博客排行 | 更多>> |

| 一周博文回复排行榜 | 更多>> |

| 1 | 台湾问题:麻将停牌 | 随意生活 |

| 2 | 川普到底卖了乌克兰没有? | 山蛟龙 |

| 3 | 梅兰芳和兩位仍然在世的入室弟 | 玉质 |

| 4 | 第一美女:《越人歌》-宋祖英 | YOLO宥乐 |

| 5 | 做这道题,知道明年你要去哪? | 末班车 |

| 6 | 关于离岸爱国 | 阿里克斯Y |

| 7 | 海外中文出版的新路基本开通, | 高伐林 |

| 8 | 70%美国大学毕业生找不到工作 | 乐维 |

| 9 | 大湾区的整合梦 | 文庙 |

| 10 | 给菓趣的回复,你至少有放风的 | renweida |